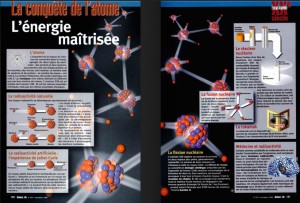

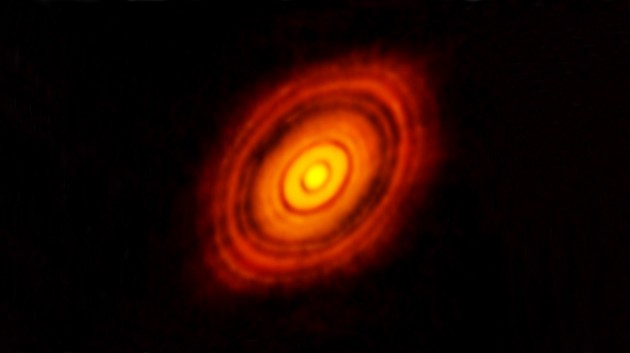

Le disque protoplanétaire qui entoure l’étoile naissante HL Tauri, observé par le réseau interférométrique Alma. Le disque s’étend sur plus de vingt milliards de kilomètres. Les divisions sombres dans le disque témoignent peut-être de la présence de planètes en formation autour de HL Tauri. Image ESO.

Cette image est tellement nette, symétrique, que l’on croirait une simulation : mais non, ce disque parfait, légèrement incliné, sillonné d’anneaux clairs et de divisions obscures montre, pour la première fois avec une surréaliste précision, la naissance d’un système planétaire… C’est le réseau interférométrique international Alma qui a permis d’obtenir cette image, deux fois plus précise que les photographies prises par le télescope spatial Hubble. Ce qu’elle montre ? Le disque de gaz et la poussières qui entoure une étoile naissante de la constellation du Taureau, HL Tauri. Surprise : les spécialistes de l’évolution stellaire ne s’attendaient pas à découvrir un disque aussi évolué autour d’un astre aussi jeune, HL Tauri étant âgée de un million d’années seulement. Mais surtout, ils ne s’attendaient pas à découvrir ces structures concentriques, qui signent probablement la naissance de planètes autour de l’étoile ! Les chercheurs pensent en effet depuis des décennies que les planètes se forment, autour de leur étoile, en grossissant, par effet boule de neige, sur leur trajectoire, à partir de petits objets, les planétésimaux. Ces objets, d’abord de la taille de météorites, puis d’astéroïdes, en accrétant la matière rencontrée sur leur trajectoire, grossissent progressivement jusqu’à devenir des planètes. Dans le même temps, leur orbite est balayée, nettoyée : c’est cela qu’a probablement photographié Alma.

HL Tauri, en haut de l’image, appartient à un groupe d’étoiles en formation, voilées dans un immense nuage de gaz et de poussière interstellaire, dans la constellation du Taureau. En bas et à droite de l’image, apparaît une autre étoile naissante, V1213 Tauri. Photo Nasa/ESA/STSCI.

Photographier, au sens « enregistrer les photons », car cette image n’a rien d’une photographie. D’abord, elle a du, contrairement à une image directe, faite avec un télescope et sa caméra, passer par un logiciel de reconstruction d’images : Alma est un interféromètre et ne prend donc pas d’images directes : ses dizaines d’antennes enregistrent les signaux – deux à deux – venus du ciel, puis une « carte » est reconstituée : c’est l’image que nous avons sous les yeux. Plus le nombre d’antennes est important, plus elle recouvrent la surface du télescope virtuel que le réseau dessine, plus la carte, donc l’image, est fiable. Ici, entre 25 et 30 antennes du réseau – qui en compte en tout soixante six – ont été utilisées.

Ensuite, l’image de HL Tauri a été prise à 1,28 millimètre de longueur d’onde, quand l’œil humain, par comparaison, est sensible à la lumière visible, entre 0,3 et 0,7 micromètre.

Une trentaine d’antennes du réseau Alma ont été utilisées pour observer HL Tauri. Afin d’obtenir la meilleure image possible, le réseau a été utilisé dans sa configuration extrême, certaines antennes étant séparées par 15 kilomètres. Alma se trouve à 5000 mètres d’altitude sur le plateau de Chajnantor, au Chili. Photo ESO.

L’avantage énorme, décisif, du réseau Alma, par rapport aux grands télescopes optiques et infrarouges, comme Hubble dans l’espace ou le Very Large Telescope européen, par exemple, c’est que, aux longueurs d’onde millimétriques, les étoiles sont pratiquement invisibles, alors que leur environnement est très lumineux. C’est cela qui rend l’image de HL Tauri enregistrée par Alma si fascinante : on n’avait jamais vu d’aussi bien, d’aussi près, un système planétaire, à part le système solaire, bien sûr… Mais observer aux grandes longueurs d’onde a un coût. La résolution (la finesse de détails) d’un télescope dépend de son diamètre et de la longueur d’onde observée. Ici, à 1,28 millimètre de longueur d’onde, le télescope virtuel dessiné par la trentaine d’antennes du réseau Alma mesurait quinze kilomètres ! L’image de HL Tauri, qui se trouve à 450 années-lumière de la Terre, a une résolution de 0,035 seconde d’arc, ce qui correspond à 750 millions de kilomètres. Le disque proto planétaire qui entoure l’étoile naissante mesure environ vingt quatre milliards de kilomètres de diamètre.

Dans les mois et années qui viennent, les astronomes qui utilisent Alma vont améliorer encore cette image fascinante de HL Tauri. D’abord, en augmentant le nombre d’antennes utilisées, ensuite en diminuant la longueur d’onde observée, avec, qui sait, à la clé, la découverte d’un embryon planétaire circulant autour de l’étoile naissante…

Serge Brunier