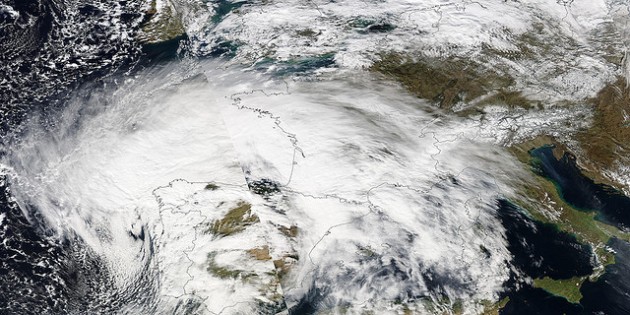

La galaxie spirale géante NGC 6872, photographiée ici par le télescope spatial Hubble, se trouve entre 200 et 300 millions d’années-lumière de la Terre, dans la constellation australe du Paon. Photo Nasa/ESA/STSCI.

C’est, aujourd’hui, la galaxie spirale la plus grande connue dans l’Univers. Plus de cinq cent mille années-lumière, d’un bout de son bras spiral à l’autre. Oui, vous avez bien lu : il faut un demi million d’années à la lumière émise par une étoile située à l’est de la galaxie NGC 6872 pour aller dessiner une constellation à l’ouest de celle-ci… NGC 6872 étant lancée dans un lent ballet gravitationnel depuis plus de cent millions d’années avec sa petite compagne, IC 4970, les deux galaxies sont soumises aux énormes effets de marées gravitationnelles qu’elles exercent l’une sur l’autre. Déséquilibrée dans sa rotation sur elle-même par IC 4970, NGC 6872 déploie deux immenses bras, dans lesquels naissent des millions d’étoiles.

Quand et comment ce vertigineux slow céleste va t-il s’achever ? Nous l’ignorons aujourd’hui. Si la vitesse de la petite spirale est suffisante, elle s’échappera du champ gravitationnel de sa grande compagne, et s’éloignera dans le cosmos, emportée par l’expansion universelle. Dans le cas contraire, et plus probablement, la course de IC 4970 autour de NGC 6872 va continuer, et, lentement, elle va s’approcher d’elle avant de fusionner. Quant aux deux bras immenses de NGC 6872, ils vont probablement se détacher lentement de leur galaxie et se perdre dans l’espace avec leurs étoiles…

C’est la plus grande galaxie spirale actuellement connue dans l’Univers : NGC 6872 mesure plus de 500 000 années-lumière de diamètre, soit cinq fois plus que notre propre galaxie, la Voie lactée. Photographie prise par le Very Large Telescope installé au sommet de Cerro Paranal, dans le désert d’Atacama, au Chili. Photo ESO.

NGC 6872 et IC 4970 se trouvent à une distance – inconnue précisément – de 200 à 300 millions d’années-lumière, dans la constellation australe du Paon. La question de l’avenir des centaines de milliards d’étoiles, et d’autant de mondes qui les accompagnent, demeurera à jamais académique : ces deux galaxies nous fuient inexorablement, emportées par l’expansion cosmique, à plus de 4500 kilomètres par seconde…

Serge Brunier

Sur ces gros-plans du couple de galaxies NGC 6872 et IC 4970, vues, à gauche, par le Very Large Telescope (VLT) et à droite par le télescope spatial Hubble, on remarque l’immense arche d’étoiles arrachées à la galaxie géante par la petite spirale. C’est la turbulence atmosphérique qui rend l’image du VLT un peu floue. L’image de Hubble, beaucoup plus nette, révèle avec précision les nébuleuses et les amas de jeunes étoiles supergéantes qui parsèment le disque de la galaxie NGC 6872. Photos ESO et Nasa/ESA/STSCI.